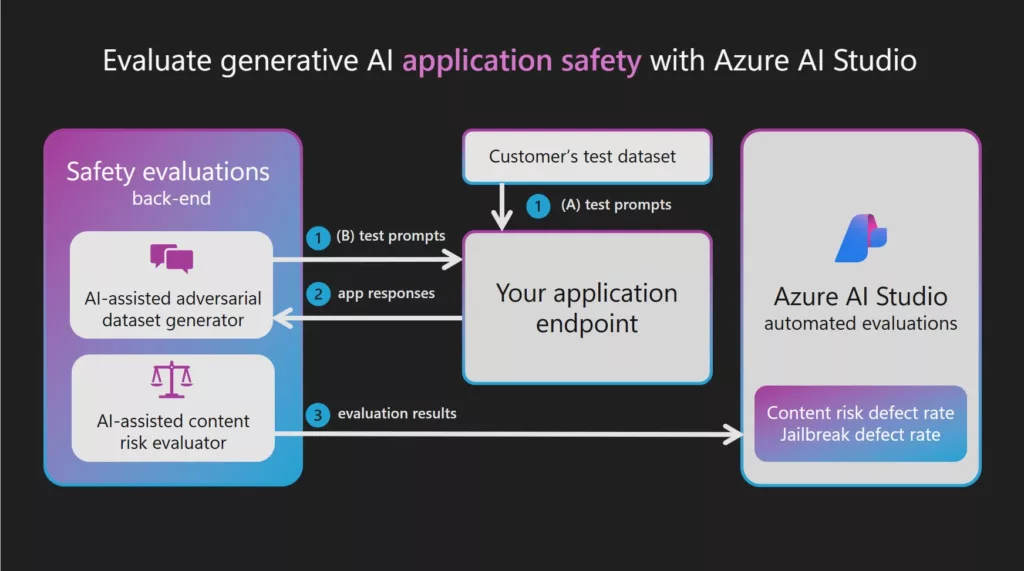

Yapay zeka destekli kalite ve performans değerlendirmelerinin bir uygulaması, yapay zeka destekli risk ve güvenlik ölçümlerinin oluşturulmasıdır. Azure AI Studio güvenlik değerlendirmeleri, yapay zeka destekli risk ve güvenlik ölçümleri oluşturmak için arka uç hizmetinde barındırılan bir Azure OpenAI GPT-4 modeli sağlar ve ardından LLM’ye bağımlı iki adımın her birini düzenler:

- Üretken yapay zeka sisteminizle saldırgan etkileşimleri simüle etme:Zararlı yanıtlar oluşturmak için hedeflenen istemler tarafından yönlendirilen tek dönüşlü veya çok dönüşlü değişimlerin benzetimini yaparak giriş ve yanıtlardan oluşan yüksek kaliteli bir test veri kümesi oluşturun.

- İçerik veya güvenlik riskleri için test veri kümenize ek açıklama ekleme:Her içerik türü ve güvenlik riski için tanımlanan önem derecesi ölçeğinden türetilen önem derecesi ve mantık ile test veri kümesindeki her etkileşime açıklama ekleyin.

Sağlanan GPT-4 modelleri saldırgan bir veri kümesi oluşturucu veya açıklama oluşturucu işlevi görmesi nedeniyle güvenlik filtreleri kapatılır ve modeller bir arka uç hizmetinde barındırılır. Bu LLM’ler ve hedeflenen saldırgan istem veri kümeleri için kullanılan istemler de hizmette barındırılır. Oluşturulan ve LLM aracılığıyla geçirilen içeriğin hassas yapısı nedeniyle, modellere ve veri varlıklarına Azure AI Studio müşterileri doğrudan erişemez.

Saldırgan hedeflenen istem veri kümeleri, kullanıcıların üretken yapay zeka sistemlerinde içerik ve güvenlik risklerini değerlendirmeye başlamalarına yardımcı olmak için Microsoft araştırmacıları, uygulamalı bilim adamları, dil uzmanları ve güvenlik uzmanları tarafından geliştirilmiştir.

Giriş istemleri ve yapay zeka sistem yanıtları içeren bir test veri kümeniz varsa (örneğin, kırmızı ekip oluşturma kayıtları), içerik riski değerlendiricisi tarafından açıklama eklemek için bu veri kümesini doğrudan geçirebilirsiniz. Kasa ty değerlendirmeleri, kırmızı ekiplerin büyük ölçekte saldırgan istemler oluşturmasını ve otomatikleştirmesini sağlayarak el ile kırmızı ekip oluşturma çalışmalarını artırmaya ve hızlandırmaya yardımcı olabilir. Ancak yapay zeka destekli değerlendirmeler ne insan incelemesinin yerini alacak ne de olası tüm riskleri kapsayan kapsamlı bir kapsam sağlayacak şekilde tasarlanmamıştır.

Jailbreak güvenlik açığını değerlendirme

İçerik risklerinin aksine, jailbreak güvenlik açığı bir LLM tarafından doğrudan ek açıklama ile güvenilir bir şekilde ölçülemiyor. Ancak jailbreak güvenlik açığı, iki paralel test veri kümesinin karşılaştırması yoluyla ölçülebilir: temel saldırgan test veri kümesi ile ilk dönüşte jailbreak eklemeleri içeren aynı saldırgan test veri kümesi. Her veri kümesine yapay zeka destekli içerik riski değerlendiricisi tarafından açıklama eklenebilir ve her veri kümesi için bir içerik riski hata oranı oluşturulabilir. Daha sonra kullanıcı, hata oranlarını karşılaştırarak ve jailbreak veri kümesinin daha fazla veya daha yüksek önem hatalarına yol açtığı durumları not ederek jailbreak güvenlik açığını değerlendirir. Örneğin, bu paralel test veri kümelerindeki bir örneğe jailbreak eklemesi olan sürüm için daha ciddi bir açıklama eklenirse, bu örnek bir jailbreak hatası olarak kabul edilir.

Desteklenen görev türleri ve yerleşik ölçümler hakkında daha fazla bilgi edinmek için bkz . Üretken yapay zeka için değerlendirme ve izleme ölçümleri.

Üretken yapay zeka uygulamalarını değerlendirme ve izleme

Azure AI Studio, yapay zeka uygulama geliştiricilerinin uygulamalarını değerlendirmesi için çeşitli farklı yolları destekler

- Oyun Alanı: İlk yolda, bir “oyun alanı” deneyimine girişerek başlayabilirsiniz. Burada, modelinizi topraklamak için kullanmak istediğiniz verileri seçme, uygulama için temel modeli seçme ve modelin davranışına yol gösterecek metaprompt yönergeleri sağlama seçeneğiniz vardır. Daha sonra bir veri kümesi geçirip uygulamanın yanıtlarını gözlemleyerek uygulamayı el ile değerlendirebilirsiniz. El ile inceleme tamamlandıktan sonra, geleneksel ölçümler veya yapay zeka destekli değerlendirmeler aracılığıyla daha kapsamlı değerlendirmeler yapmak için değerlendirme sihirbazını kullanmayı tercih edebilirsiniz.

- Akışlar: Azure AI Studio prompt akış sayfası, LLM’ler tarafından desteklenen yapay zeka uygulamalarının tüm yaşam döngüsünün akışını oluşturmak için uyarlanmış özel bir geliştirme aracı sunar. Bu yol sayesinde LLM’leri, istemleri ve Python araçlarını görselleştirilmiş bir grafik aracılığıyla bağlayan yürütülebilir akışlar oluşturabilirsiniz. Bu özellik, akışların hata ayıklamasını, paylaşımını ve işbirliğine dayalı yinelemelerini basitleştirir. Ayrıca, büyük ölçekli testlerle istem varyantları oluşturabilir ve bunların performansını değerlendirebilirsiniz.

‘Akışlar’ geliştirme aracına ek olarak, kod öncelikli SDK deneyimini kullanarak üretken yapay zeka uygulamalarınızı geliştirme seçeneğiniz de vardır. Seçtiğiniz geliştirme yolundan bağımsız olarak, oluşturduğunuz akışları değerlendirme sihirbazı aracılığıyla, ‘Akışlar’ sekmesinden veya SDK/CLI deneyimi aracılığıyla değerlendirebilirsiniz. ‘Akışlar’ sekmesinden özelleştirilmiş bir değerlendirme sihirbazı kullanma ve kendi ölçümlerinizi ekleme esnekliğine bile sahipsiniz. - Doğrudan Veri Kümesi Değerlendirmesi: Uygulamanızla son kullanıcılar arasında etkileşimler içeren bir veri kümesi topladıysanız, bu verileri “Değerlendirme” sekmesinde doğrudan değerlendirme sihirbazına gönderebilirsiniz. Bu işlem, otomatik yapay zeka destekli değerlendirmelerin oluşturulmasını sağlar ve sonuçlar aynı sekmede görselleştirilebilir. Bu yaklaşım, veri odaklı bir değerlendirme yöntemine dayalıdır. Alternatif olarak, SDK/CLI deneyimini kullanarak konuşma veri kümenizi değerlendirme ve Azure AI Studio aracılığıyla değerlendirmeler oluşturup görselleştirme seçeneğiniz vardır.

Bu kanallardan herhangi birinden uygulamalarınızı, akışlarınızı veya verilerinizi değerlendirdikten sonra, üretken yapay zeka uygulamanızı dağıtmaya devam edebilir ve kullanıcılarınızla yeni etkileşimler kurarken üretim ortamında kalitesini ve güvenliğini izleyebilirsiniz.

Kaynak : https://learn.microsoft.com/tr-tr/azure/ai-studio/